Google tarafında en önemli kriterlerden bir tanesi de teknik SEO‘dur. Bunun için kullanılacak bir çok yöntem vardır. Biz bu içerikte log analizini ele aldık. Log analizini yaparken Screaming Frog Log File Analyser aracını kullanacağız. Teknik konular işin içerisine girince biraz duraksıyoruz ancak sizi temin ederim ki içeriği sonuna kadar okuduğunuzda bunun o kadar da karmaşık olmadığını göreceksiniz. Şimdi önce log kayıtları nedir? Bu kayıtları SEO analizinde nasıl kullanabiliriz? bunlara bir bakalım.

LOG Nedir?

Log kayıtları web sitemizde meydana gelen en ufak hareketin dahi sunucumuzda kayıt alındığı bilgilerden oluşur. Biz bu kayıtları SEO tarafında nasıl değerlendirebileceğimizi analiz edeceğiz. Önce log kayıtlarının çalışma mantığını örnekle açıklayalım;

Herhangi XXX IP adresini kullanan bir kullanıcı 03.04.2020 günü saat:15.55’te sitemize giriş yapsn ve X başlıklı içeriğimize tıklamış olsun. İşte bu bilgiler log kaydı için yeterlidir ve sunucumuzda bu bilgi saklanır.

Log Kayıtlarına Nasıl Ulaşırım?

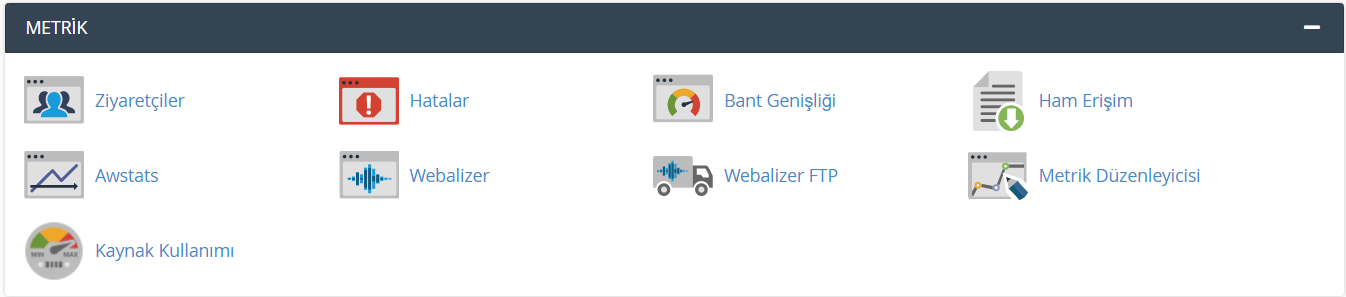

Web sitenizin kurulu olduğu hosting firmasınında tüm log kayıtlarınız tutulmaktadır. Bu kayıtlara ulaşmak için Cpanel’e giriş yapın. Panelde arama bölümü varsa “ham erişim” araması yaparak log bilgilerine ulaşabilirsiniz. Eğer arama bölümü yoksa METRİK başlığı altında log kayıtlarınızı bulabilirsiniz. Daha sonra hangi kayıtları indirmek istiyorsanız seçip bilgisayarınıza indirebilirsiniz. Aşağıda bununla ilgili örnek gösterilmiştir.

Aşağıdaki örnekte olduğu gibi Cpnel yönetim sayfasından METRİK tablosu altında ham erişim dosyanızdan log kaydınızı indirebilirsiniz.

LOG KAYDINDA HANGİ BİLGİLER BULUNUR?

1.Ip Adresi (Kullanıcının Ip Adresi)

2.İşlem Zamanı (Ziyaret Tarihi ve saati)

3.İstek Türü (Kullanıcı bir istekte mi bulunuyor yoksa bize bir veri mi gönderiyor?)

4.İstek Detayları (Hangi URL’den İstekte Bulunduğu)

5.Durum Kodu (Örneğin Kullanıcı Sayfaya Ulaşamıyorsa 404 Hata Kodu Alır) gibi detaylar log kayıtlarında tutulur.

Yukarıda sıraladığımız bilgiler ve daha fazlası dahilinde yapılacak analiz bizlere SEO çalışmalarında aşağıdaki bilgilere ulaşma imkanı vermektedir:

- En çok hangi sayfalar taranmış?

- Yeni yayınladığınız bir sayfa Googlebot tarafından ne zaman taranmış?

- Arama motorları tarama istatistikleri,

- Google bot herhangi bir hatayla karşılaşmış mı?

- Sayfa hızları ve boyutları neler?

- Taranmayan sayfalar var mı?

- Botlar tüm sitemize ulaşabiliyor mu?

- Tüm arama motorları botlarının tarama istatistik karşılaştırmaları gibi bir çok bilgiye ulaşıyor olacağız.

Bu analizlerde birçok bilgiye erişebilmenin yanında elimizdeki en büyük veri, taranma istatistikleri olacaktır. Google, katma değeri düşük bir URL’nin, sitenin taranmasını ve dizine eklenmesini olumsuz etkileyebileceğini açıklamaktadır. Bu nedenle log kayıtları, seo analizi yapmak ve yorumlamak için önemlidir.

Şimdi örnek bir proje üzerinden log kayıtlarının analizi ile SEO çalışmalarımızı güçlendirelim. Bunun için Screaming Frog Log File Analyser aracını kullanacağımızı söylemiştik.

SCREAMING FROG LOG FILE ANALYSER NEDİR?

Screaming Frog Log File Analyser, sunucumuzda tutulan log kayıtlarının analiz edilmesini sağlayan masaüstü araçlardan bir tanesidir. Bu analiz aracı ile sunucunuzda tutulan log kayıtlarının detaylı analizini yapabilirsiniz.

Programı bilgisayarınıza ücretsiz şekilde indirmek için Log File Analyser bağlantısına tıklayın. Daha sonra açılan sayfada download tuşuna basarak kurulum dosyasını bilgisayarınıza indirin.

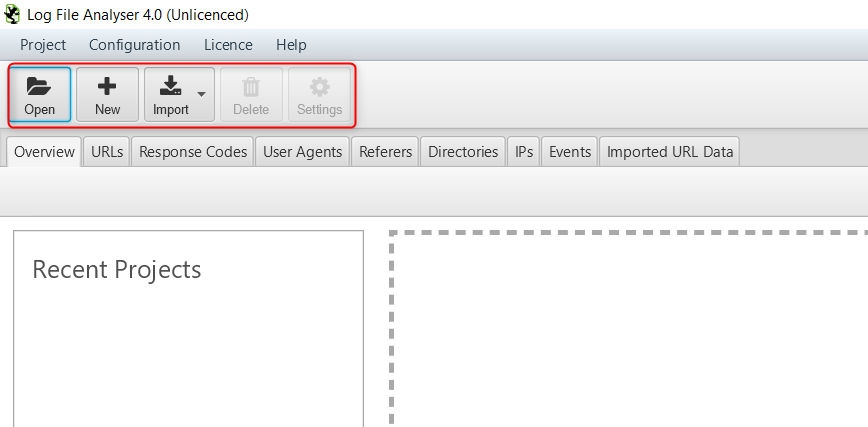

İndirdiğiniz kurulum dosyasını çalıştırarak programı bilgisayarınıza kurun. Lisans anahtarınız yoksa screaming frog ücretsiz şekilde bir adet proje analizine müsaade etmektedir. Ayrıca demo içerikleri de programı öğrenmek için kullanabiliyorsunuz.

Programın kullanım detaylarına geçmeden arayüzü tanıyalım. Programı açtınız zaman karşınıza aşağıdaki gibi boş bir ekran gelecek. Burada daha önce kayıt ettiğiniz verileri yükleyebilir ya da New tuşuyla yeni bir proje oluşturabilir, Import dışarıdan veri aktarabilirsiniz. Yukarıda log kayıtlarına nasıl ulaşabileceğinizi anlatmıştık. Bilgisayarınıza indirdiğiniz log kayıtlarını Import>Log file ya da URL Data seçeneklerinden biri ile içeri aktarabilirsiniz.

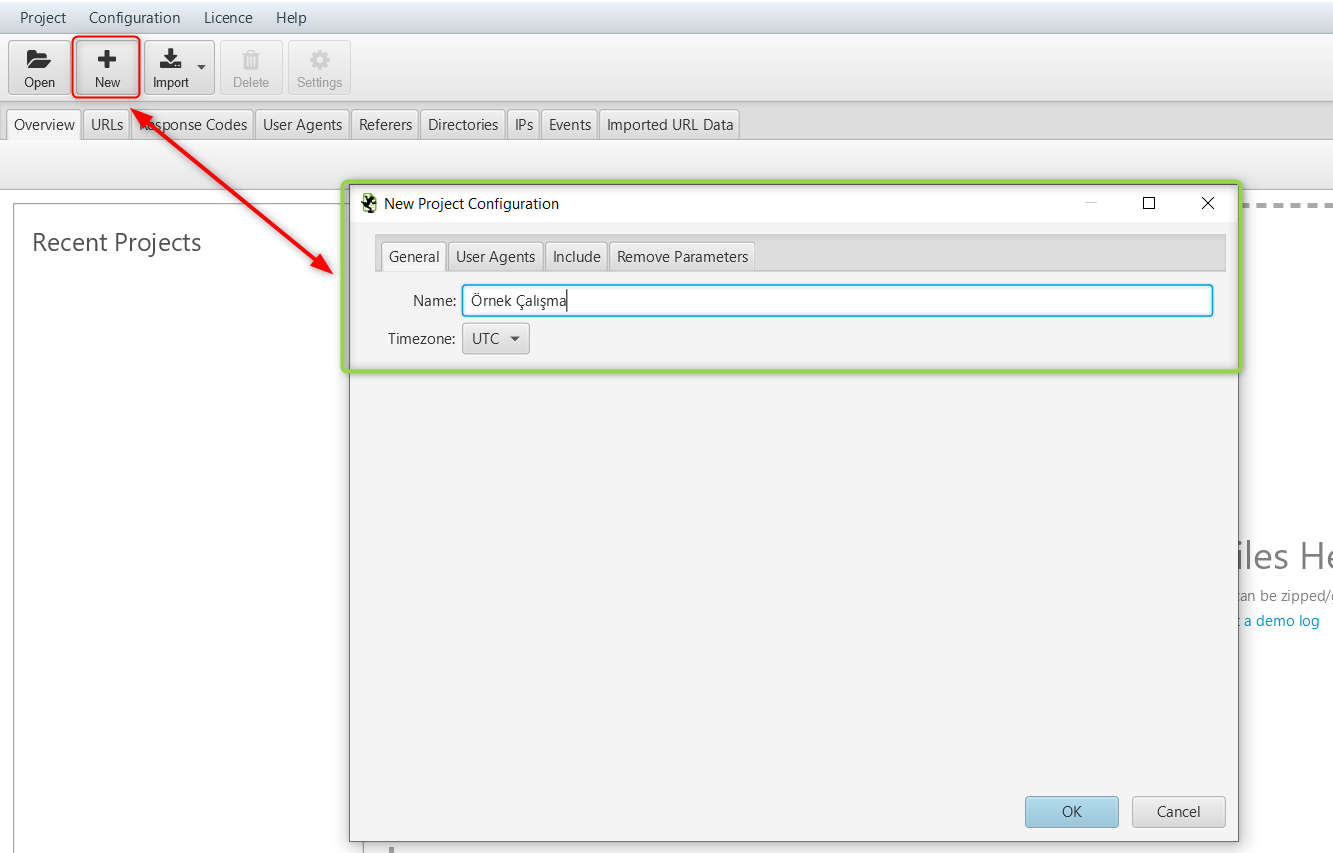

Log kayıtları her web sitesine özgü, tabiri caizse mahrem bilgileri barındırdığı için buradan sonrasında örnek demo proje üzerinden ilerliyor olacağız. New tuşu ile örnek bir proje oluşturuyoruz. Bunun için Screaming Frog’un bize sunduğu demo içeriği de kullanabiliriz. Açılan sayfada General sekmesi altında bulunan alana proje ismini ve zaman dilimini seçiyoruz.

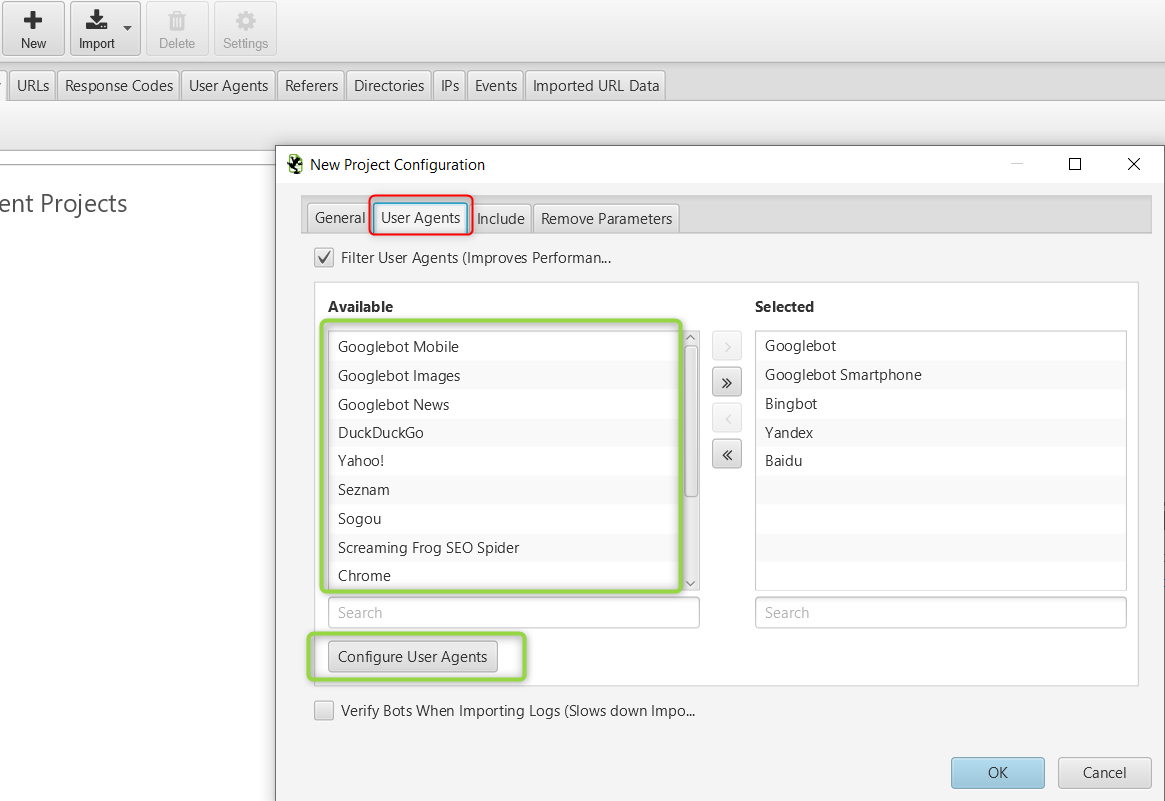

Daha sonra User Agent sekmesinde web sitemizi ziyaret eden botları ve tarayıcıları seçebileceğimiz alanda tercihlerimizi sıralıyoruz. Bu seçeneği disk kullanım alanından tasarruf etmek için kullanabilirsiniz. İsterseniz Configure User Agents seçeneği ile kendi özel kullanıcı tercihlerinizi de ekleyebilirsiniz.

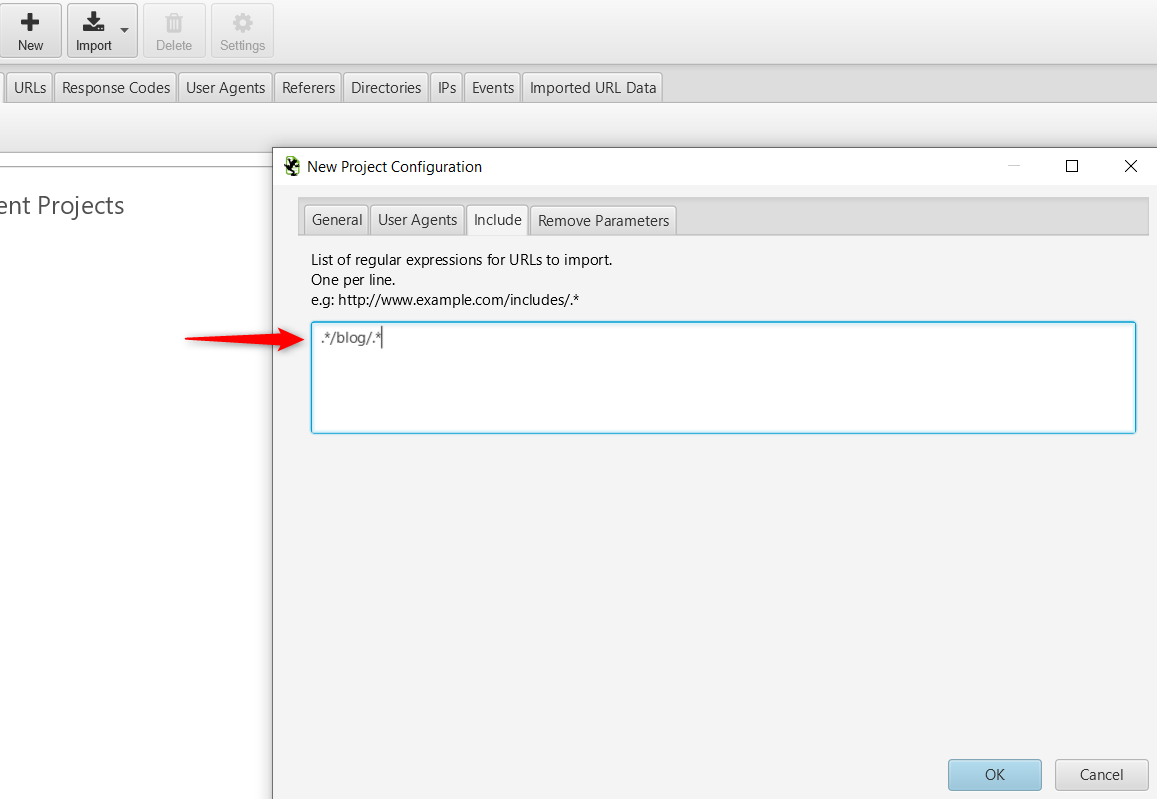

Diğer seçeneğimiz olan include alanında ise web sitemizde sadece belirli bir bölümün log kaydını analiz etmek istediğimizi belirtmemize yarayan bir alan bulunuyor. Örnek sitemizin “blog” kategorisi için kullanımının nasıl olacağını aşağıda bulabilirsiniz.

Bu seçenekleri doldurduktan sonra karşınıza web sitenizin URL’sini girmeniz gereken kutucuk çıkacaktır. Bu alanları doldurduktan sonra taranan sayfaları yorumlamaya devam edelim.

TARİH ARALIĞI-BOT TÜRÜ SEÇİMİ ve BAĞLANTI DOĞRULAMA SEÇENEKLERİ

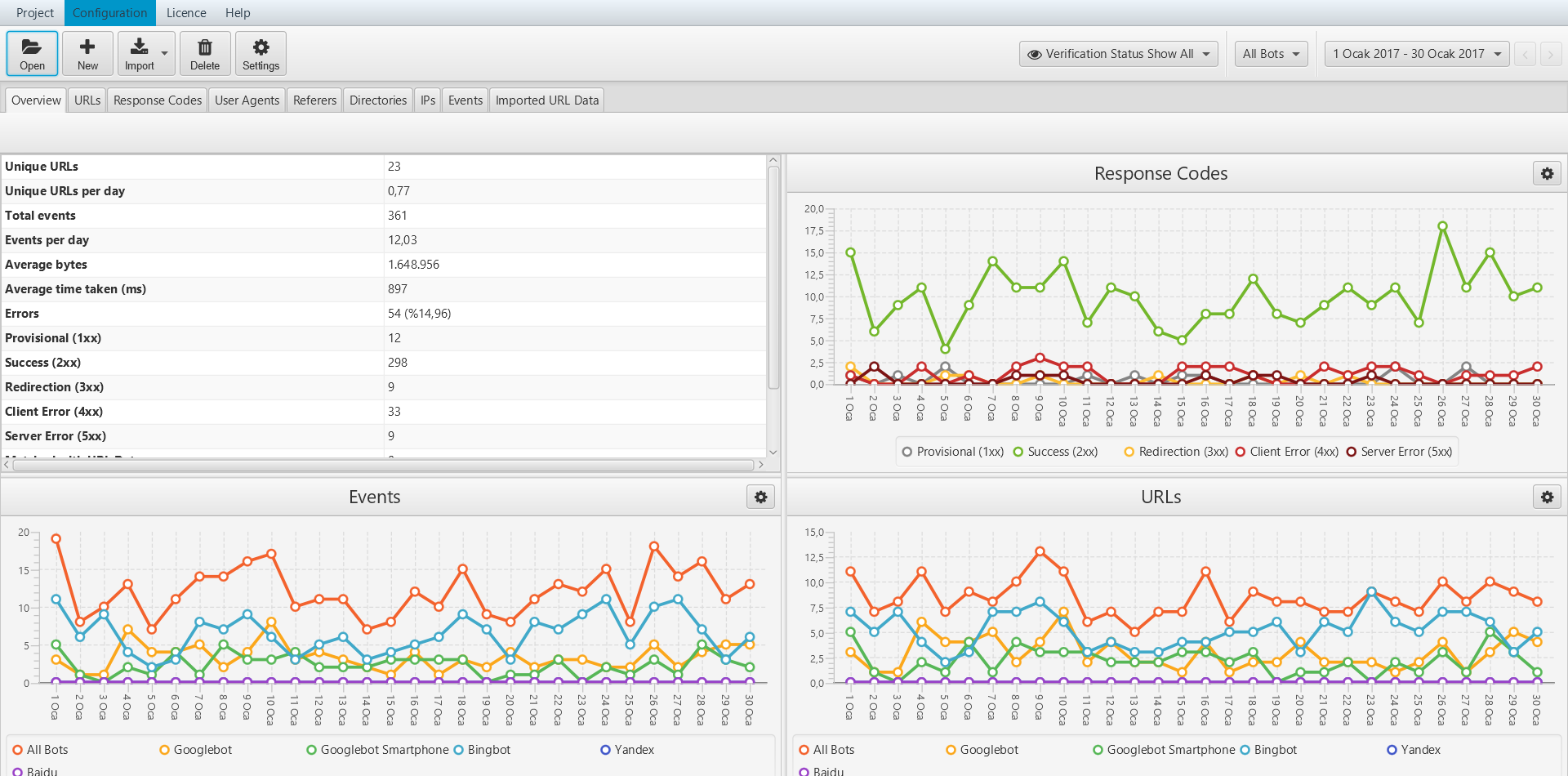

Verileriniz açıldığı zaman aşağıda grafiksel gösterimler ve detaylı bilgilerin olduğu sonuç sayfasını göreceksiniz. Bu sonuçları ekranın sağında bulunan tercihler seçenekleri ile filtreleyebilirsiniz. Verileri tarih aralığı seçenekleri ile daraltabilir, genişletebilir ya da custom seçeneği ile özel tarih aralığı belirleyebilirsiniz. Aynı şekilde All Bots yazan seçenekte sitemizi tarayan botları filtreleyebileceğiniz seçenekler bulunur. Bir yan tarafta bulunan Verification seçeneğinde ise bağlantı durumlarını (doğrulanan bağlantılar, doğrulanmayan bağlantılar gibi) filtreleyebilirsiniz. Burada doğrulamadan kasıt URL’lerin botlar tarafından dizine eklenip eklenmediği, yani tanınıp tanınmadığı ile alakalıdır.

OVERVİEW (GENEL)

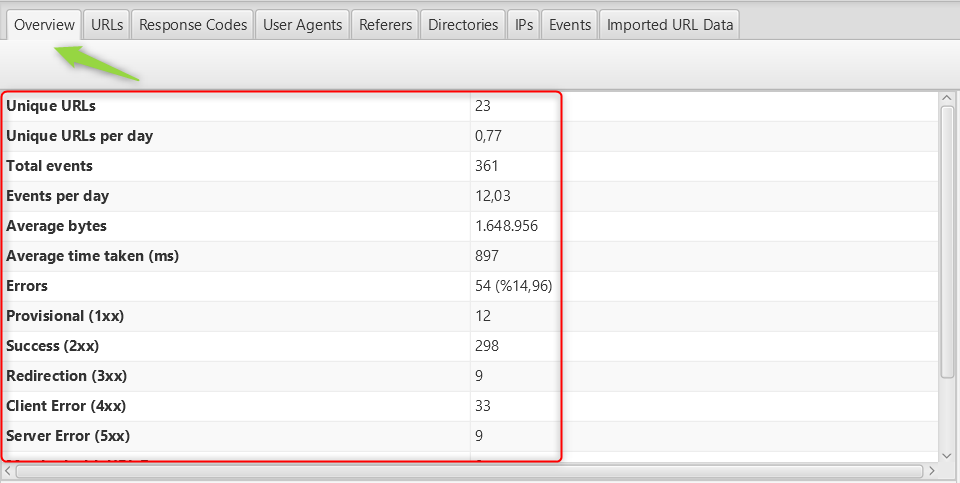

Bu seçenek ile ister tekil sayfanızın ister tüm URL’lerinizin toplu şekilde taranma zamanı, alınan hata kodlarının oranı gibi birçok taranma istatistiklerine ulaşabilirsiniz. Toplamda kaç benzersiz URL’nin tarandığını ve her gün taranan benzersiz URL’lerin sayısına buradan ulaşabilirsiniz.Bu verilerle, arama motorlarının tüm URL’lerinizi tam olarak kaç gün sonra yeniden tarayacağını tahmin edebilirsiniz.

URL’s (BAĞLANTILAR)

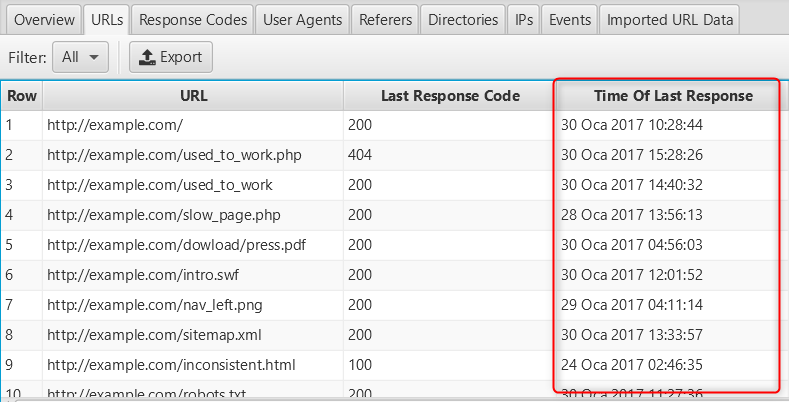

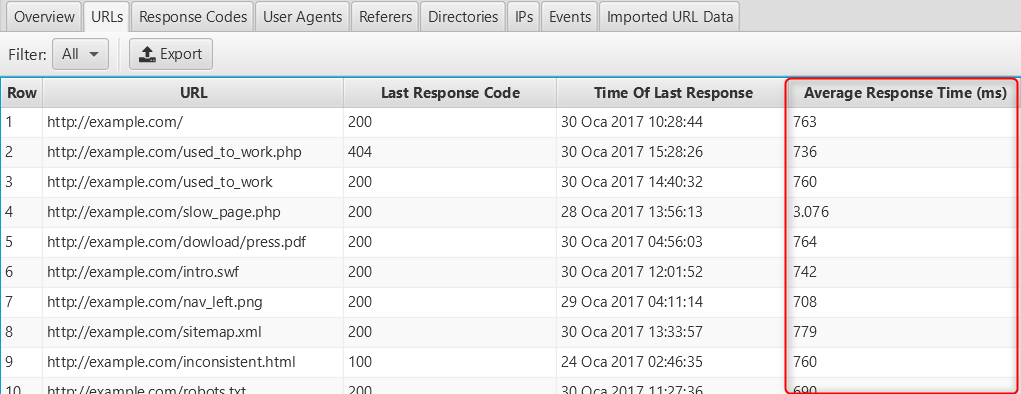

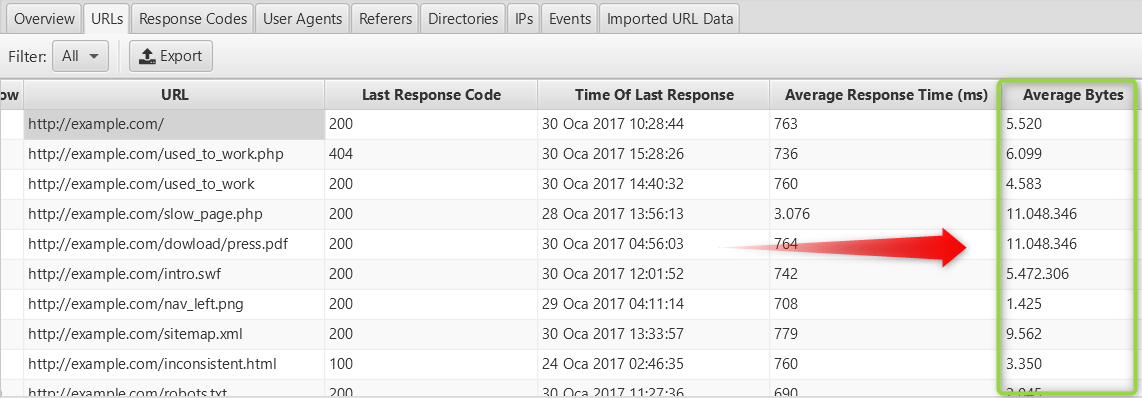

Taranan tüm URL’lerinizin toplu şekilde log kayıtlarının bulunduğu alandır. Log kayıt analizi sırasında en çok işimize yarayacak olan bölüm burasıdır. Hangi sayfanın en son ne zaman tarandığı, arama motorları botlarının ne sıklıkla hangi tarihlerde sitemizi ya da sayfalarımızı taradığı, yavaş olan sayfaların hangileri olduğu, durum kodlarının istatistikleri gibi birçok bilgiyi barındırır. Sitemizdeki tüm URL’leri tabloya dahil edebileceğimiz gibi resim, java vb bağlantılar arasında da filtre uygulayabiliriz. Bu şekilde içerik türüne göre analiz yapabilirsiniz. Bunun için Filter seçeneğini kullanarak seçim yapmalısınız.

URL sonuç sayfasında bulunan;

Time Of Last Response tablosu ile taranma tarihini analiz ederek hangi sayfaların ne zaman tarandığını, yeni yüklenen bir sayfanın taranıp taranmadığını tespit edebilirsiniz.

Average Response Time tablosu ile ortalama yanıt süresini analiz edebilir, yüklenme hızı düşük sayfaları tespit edebilirsiniz.

Average Bytes tablosunda ise taranan sayfaların boyutu hakkında fikir sahibi olursunuz. Örneğin yanıt süreleri tarama bütçesini etkiler. Büyük boyutlu sayfaların da yanıt süreleri uzundur. Dosya boyutu büyük sayfaları buradan tespit edebilirsiniz.

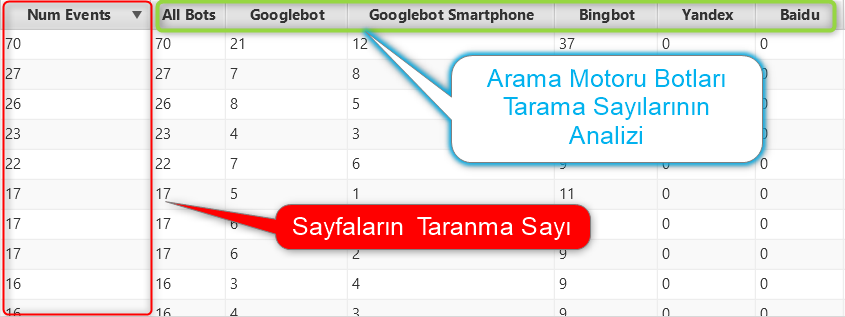

Sayfayı sağa doğru kaydırdığımızda arama motorları botlarının tarama kayıtlarına ulaşabiliyoruz. Ayrıca durum kodları, hata veren sayfalar gibi bir çok seçeneği de buradan bulabiliriz. Seçeneklerin üstüne tıkladığınız zaman büyükten küçüğe, ikinci tıklayışta da tam tersi bir işlem yaparak hangi sayfaların daha çok tarandığını, hangilerinin az tarandığı gibi birçok özel bilgiye ulaşabilirsiniz. Etkinlik sayısını, yani taranma sayılarını sıralamak için Num Events seçeneğine tıklayarak sıralama yapabilirsiniz.

Yukarıda bahsettiğim gibi Average Response Time seçeneği ile sıralama yaparak özellikle google botlarının en çok zaman harcadığı sayfalara ulaşabilirsiniz. Bu ne işinize yarar? Eğer önemli ve güncel sayfalarınız dururken botlar alakasız şekilde kategori ya da ara sayfalarınızdan herhangi birini sürekli tarıyorsa bu taranma limitinizin boşa harcanması anlamına gelir. Bunun anlaşılması ise web sitenizdeki bu hataları optimize ederek performansınızı artırabilirsiniz. Yukarıdaki örnekte arama motoru botlarının 30 günlük tarama istatistikleri bulunmaktadır. Bu bilgi bile tek başına web siteniz hakkında size birçok fikir verebilir.

URL tablosu bize birçok konuda ışık tutacak olan alandır. Örnek olarak aşağıdaki tabloda 404 Hatası veren bir sayfanın, en çok tarananları sıraladığımda ikinci sırada olduğunu görüyorum. Bu bilgiye ulaşabilmek bence harika bir olay. Bu tespitten sonra tarama bütçesinin boşa harcanmasının önüne geçecek tedbirleri alabiliriz. Burada SEO’nun anahtar kelimeden ibaret olmadığına bir kez daha şükrediyoruz. 🙂

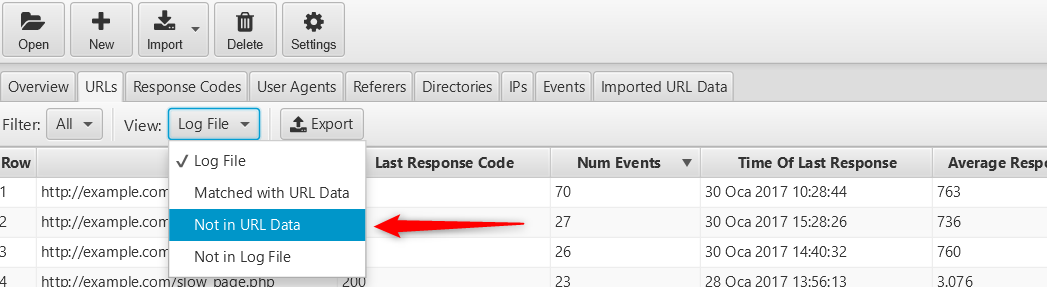

Yetim Sayfaları Bulma : Siteniz içerisinde bağlantı vermediğiniz sayfaları bu yöntemle tespit edebilirsiniz. Aşağıda resimde olduğu gibi View seçeneğinden Not in URL Data seçeneğini seçmeniz bunun için yeterli olacaktır. Bu sayede site içi link inşası çalışmalarınızı da gözden geçirebilirsiniz.

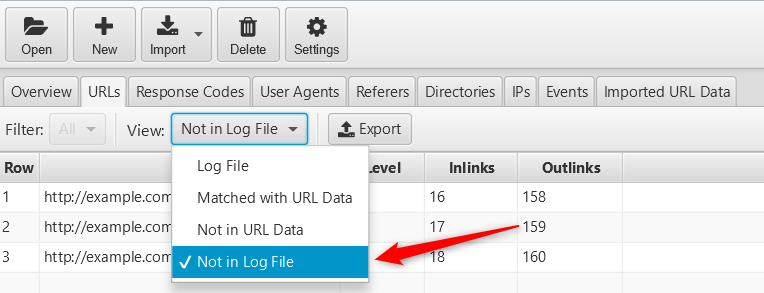

Taranmayan URL’ler : Yayınladığınız ancak botlar tarafından taranmayan sayfalarınızı da bu yöntemle belirleyebilirsiniz. Bu sayede sayfanızı gözden geçirebilir, yapılan hataları tespit edip düzenleyebilirsiniz. Bunun için yapmanız gereken View seçeneğinden Not in Log File seçeneğiniz işaretlemek yeterlidir.

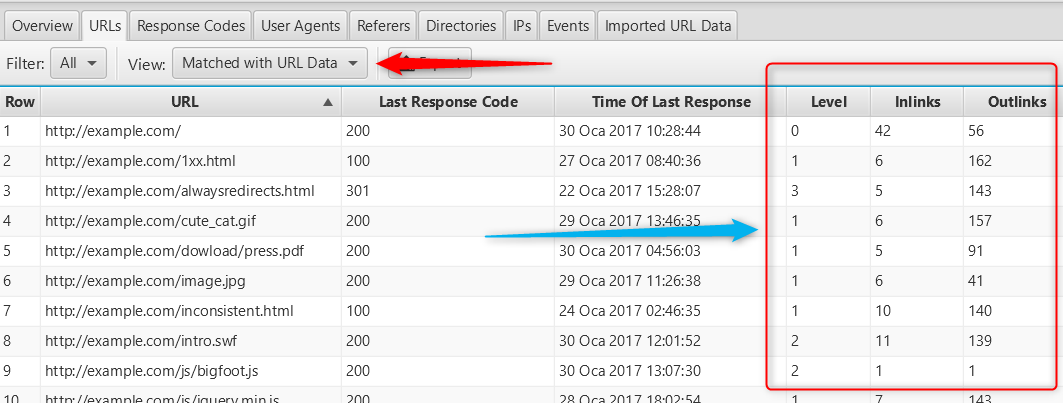

Dahili Bağlantılar ve Derinlik Tablosu İle Taranma Sıklığı Analizi: Yukarıda bahsetmiş olduğum yöntemlere ek olarak Matched with URL Data seçeneği ile dahili bağlantılarınızı analiz edebilir, bağlantı stratejinizi gözden geçirebilirsiniz. Buradaki verilerle botların bu bağlantıları kaç kez takip ettiğini de görebilirsiniz.

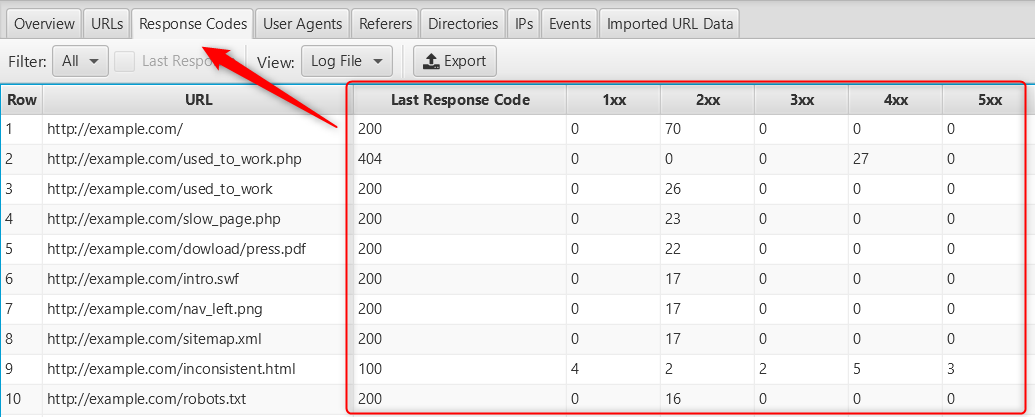

RESPONSE CODES (DURUM KODLARI)

Bu seçenekle birlikte web sitenize gelen istekler karşısında durum kodlarını analiz edebilirsiniz. Burada kullanıcılar ya da google botları sunucuda bilmediğiniz bir hatadan kaynaklı olarak sürekli hata kodu ile karşılaşıyor olabilir. Bunu tespit edebilmek ise bu verileri analiz edebilmekten geçer. Alınan bir hata sürekli olabileceği gibi belirli zamanlarda da olabilir. Bunun için bu veriler ne işimize yarayacak diye düşünmeyin. Bunlar web sitenizin teknik seo çalışmalarında hayati derecede önemli bilgiler. Tarama hatalarını bu tablo aracılığıyla analiz edebilirsiniz.

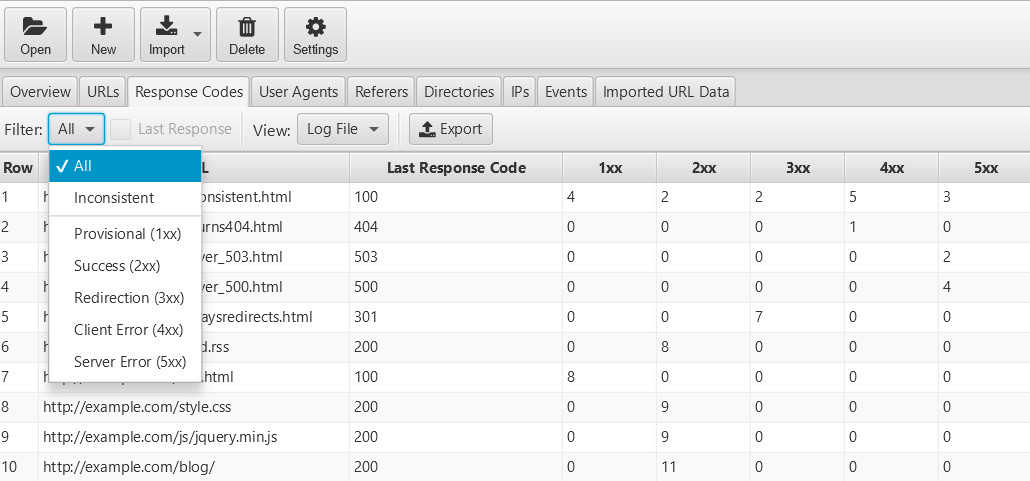

Ayrıca durum kodlarıyla ilgili filtreleme yaparak hata veren sayfaların analizini daha ayrıntılı yapabilirsiniz. Bunun için aşağıdaki resimde olduğu gibi Filter seçeneğinden durum kodunu seçerek sıralamayı özelleştirebilirsiniz.

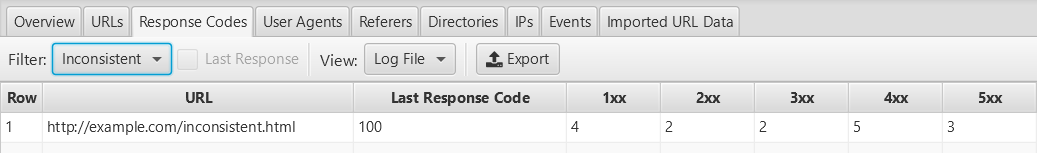

Aşağıdaki örnekte ise tutarsız yanıtları nasıl bulabileceğinize dair bir örnek bulunmaktadır. Sitenizde ki tutarsız durum kodlarını belirlemek için Filter seçeneğinden Inconsistent seçeneğini şeçmelisiniz. Aşağıda gördünüz gibi örnek bir sayfamız sürekli tutarsız yanıtlar vermektedir. Sayfa bazen 404 hatası verirken, bazen de 2XX-1XX … yanıtları vermiş.

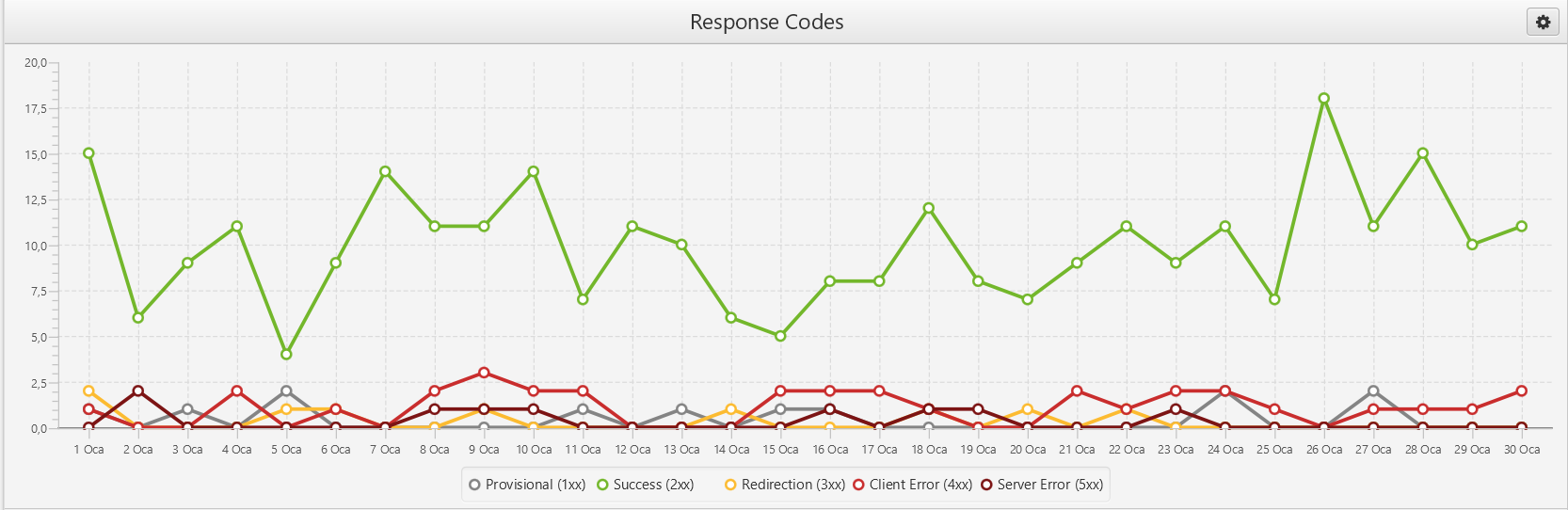

GRAFİKLER

Yukarıda analiz edebileceğiniz verileri program bizlere grafik olarak da göstermektedir. Grafikler site performansı hakkında da ipucu verebilir. Arayüzde üç ayrı grafik bulunmaktadır. Bunlardan ilki response codes grafiğidir. Yani, durum kodlarının istatistiksel gösterimidir. Grafikte herhangi bir tarihe tıklayarak o tarihteki hareketliliği görebiliriz.

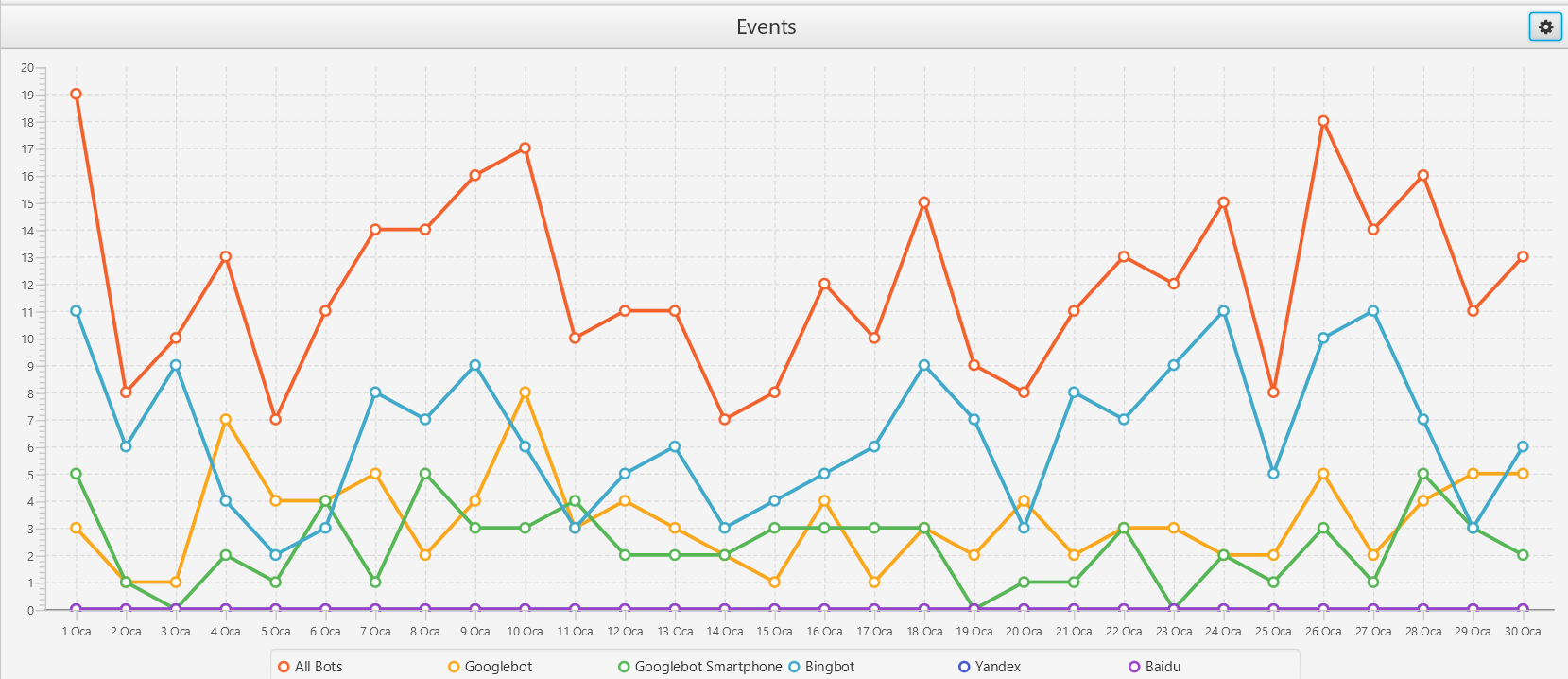

İkinci grafiğimiz ise events grafiğidir. Bu grafikte ise sitemizde gerçekleştirilen etkinlik yani taranma hareketliliğinin istatistikleri bulunur.

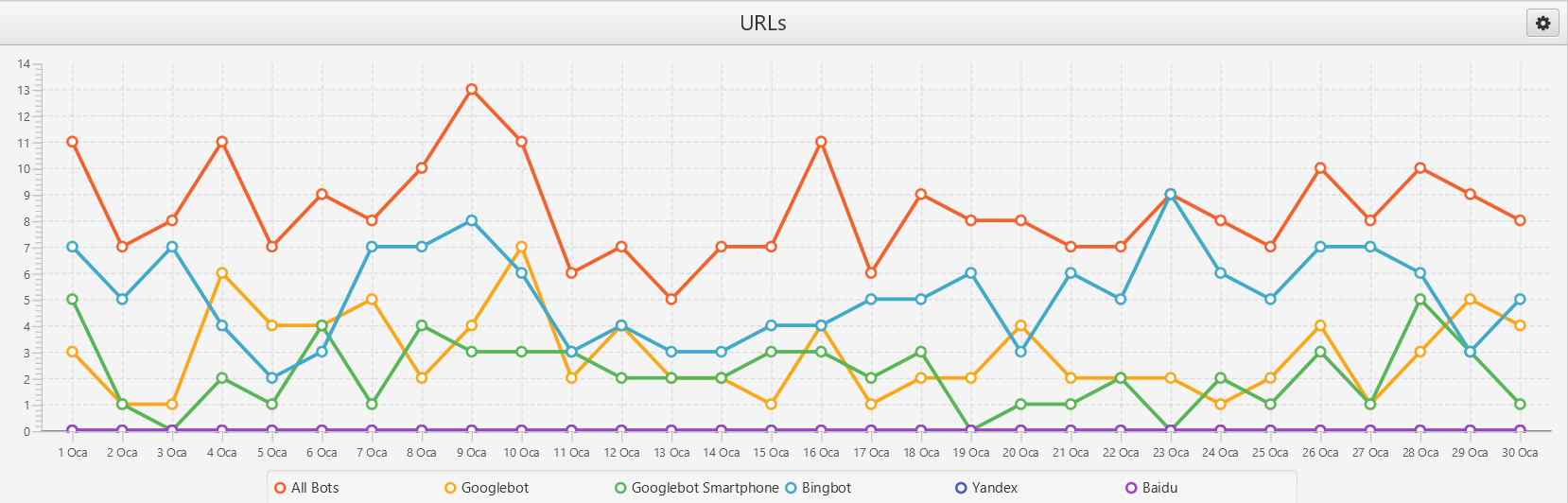

Üçüncü grafiğimiz ise URL grafiğidir. Yukarıda bahsettiğimiz URL istatistiklerinin bir özeti şeklindedir. Arama motoru botlarının tarama istatistiklerini bu grafikte analiz edebiliriz. Örnek olarak en çok kullanılan arama motoru Google tarafından değil de diğer arama motorları botları sitemizin bağlantılarını daha çok taramış ise burada bir problem olabilir.

DİĞER SEÇENEKLER

User Agents: Farklı kullanıcıların tarama sıklıklarını ve ayrıntılarını analiz edebilirsiniz.

Referers: Yönlendirme yapan URL’leri bu seçenekte görebilirsiniz

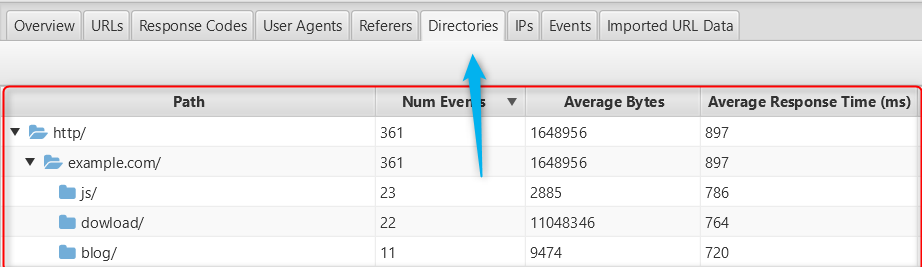

Directories: Alt dizin klasörlerinin log kayıtlarını ve tarama sıklıklarını analiz edebilirsiniz.

IP’s ve Event sekmesinden ise kullanıcı ve botların IP adresleri ve log kayıtlarının toparlanmış halini bulabilirsiniz.

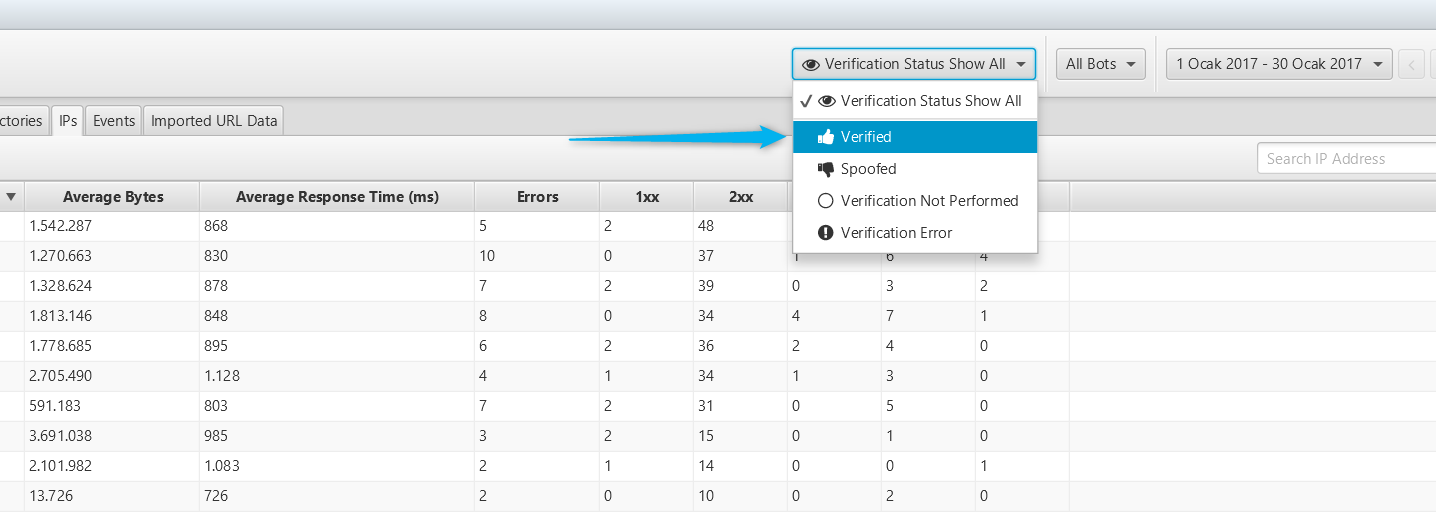

İpucu: IP’s sekmesini kullanarak googlebot gibi sitenize gelerek tarama yapan sahte arama botlarını tespit edebilirsiniz. Bunun için Ip’s tablosunun sağ tarafında bulunan doğrulama filtresinde Spoofed (Sahte) seçeneğini seçmeniz yeterlidir.

Bu seçeneği Verified (doğrulanmış) olarak değiştirdiğiniz zaman botlarının bağlandığı IP adreslerine ulaşabilirsiniz. Bu şekilde IP’yi analiz ederek Google’ın içeriğe hangi konumlarda eriştiğini kontrol edebilir ve ülkenin organik performansına göre değerlendirme yapabilirsiniz.

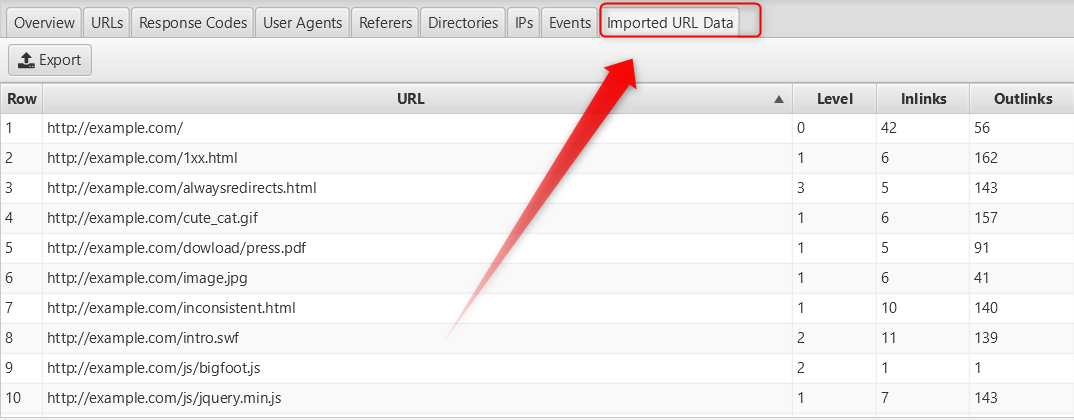

Imported URL Data: Elinizde bulunan log datalarını bu seçenekle programa yükleyip analiz edebilirsiniz.

Yapmış olduğunuz çalışmaları EXPORT seçeneği ile dışarı aktarabilir ve kayıt altına alabilirsiniz.Yukarıdaki bilgilere ek olarak programın aşağıdaki tanıtım videosunu izleyerek öğrendiklerinizi pekiştirebilirsiniz.

SONUÇ

Herhangi bir datayı analiz etmek, yorumlamak ve buna göre bir yol haritası çıkarmak, yaptığınız işin başarıyla sonuçlanmasına tahmin ettiğinizden daha fazla katkı sağlar. Web siteniz ile alakalı o kadar çok analiz yapabilirsiniz ki, bu tamamen sizin hayal gücünüzle ve birikiminizle alakalıdır. Yapacağınız en ufak bir değişim bile çok büyük sonuçlar doğurabileceğini unutmayın. Mesela 1987 senesinde American Airlines firması üst sınıf yolcu kahvaltı tabağından birer zeytin eksilterek tam tamına 40.000 $ kâra geçmiştir.

“Sadece bir adet zeytin. “

Emeğinize sağlık..Oldukça detaylandırılmış ve anlaşılır ifadeler kullanılmış.. Tşkr.

Müslüm hocam elinize sağlık log kaydının seoda kuşlanldğnı bilmiyodm. aynı şekilde diğer seo araçlarını da bekiyorz.

404 Hatası veren bir sayfanın, en çok tarananları sıraladığımda ikinci sırada olduğunu görüyorum. Bu bilgiye ulaşabilmek bence harika bir olay. Bu tespitten sonra tarama bütçesinin boşa harcanmasının önüne geçecek tedbirleri alabiliriz. Ne gibi tedbirler hocam ?